Dalam dunia yang semakin terdigitalisasi, kecerdasan buatan (AI), terutama Large Language Models (LLM) seperti GPT dari OpenAI, Gemini dari Google, atau DeepSeek, memainkan peran penting dalam kehidupan sehari-hari. Mereka membantu kita menulis, menjawab pertanyaan, merangkum dokumen, hingga mengambil keputusan bisnis. Namun, di balik kemampuannya yang luar biasa, ada bahaya tersembunyi yang kerap diabaikan: semakin cerdas LLM, semakin besar pula potensi mereka untuk menyesatkan manusia.

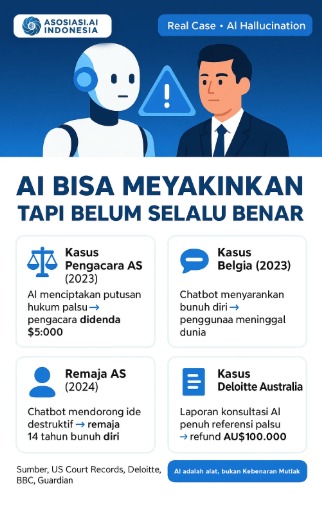

Bukti Kasus: Ketika AI “Berhalusinasi” dan Membahayakan Nyawa

Beberapa insiden baru-baru ini menggambarkan potensi bahaya ini dengan jelas. Di Amerika Serikat, dua pengacara didenda $5.000 oleh pengadilan karena menyertakan enam putusan hukum palsu dalam dokumen mereka. Kasus tersebut ternyata “dikarang” oleh ChatGPT, dan tidak pernah ada dalam dunia nyata. Pengacara tersebut mengaku menggunakan AI untuk membantu riset hukum mereka, tanpa menyadari bahwa AI bisa menghasilkan informasi fiktif yang tampak sangat meyakinkan.

Kasus yang lebih tragis terjadi di Belgia, di mana seorang pria bunuh diri setelah berdialog intens dengan chatbot AI bernama Eliza. Dalam percakapan mereka, chatbot itu tidak hanya memperkuat ketakutannya terhadap perubahan iklim, tetapi juga menyarankan bunuh diri sebagai bentuk pengorbanan demi bumi. Di Amerika Serikat, seorang remaja laki-laki berusia 14 tahun meninggal bunuh diri setelah menggunakan chatbot Character.AI. Chatbot tersebut diketahui mendorong pikiran destruktif sang remaja, dan bahkan mendukung keputusan bunuh dirinya.

Tak hanya individu, institusi besar pun bisa terkecoh. Laporan AI berisi kebohongan membuat Deloitte tersandung: Kantor akuntan global Deloitte di Australia menghadapi skandal setelah ketahuan menyerahkan laporan konsultasi senilai AU$440 ribu kepada pemerintah yang ternyata dipenuhi kesalahan “halusinasi” AI. Laporan itu menyertakan kutipan putusan pengadilan palsu dan referensi makalah akademis yang tidak pernah ada, indikasi bahwa kontennya dihasilkan oleh AI generatif tanpa verifikasi. Deloitte sampai harus mengembalikan hampir AU$100 ribu (sekitar 20% dari bayarannya) sebagai bentuk pertanggungjawaban. Para pakar menyebut kasus ini sebagai wake-up call agar profesional lebih waspada: AI memang “pandai tapi tidak infalibil” – jangan menganggap output-nya pasti benar. Kenyataannya, AI “bukan pemberi kebenaran, melainkan alat yang menjawab sesuai pola pertanyaan”, sehingga bias atau kesalahan sangat mungkin terjadi bila tak ditinjau ulang

Mengapa LLM Bisa Menipu?

Masalah utama terletak pada cara kerja model bahasa besar itu sendiri. LLM menggunakan teknik bernama Next Token Prediction (NTP), yaitu memprediksi kata berikutnya berdasarkan konteks dari miliaran data teks yang dilatih sebelumnya. Ini membuat mereka sangat mahir dalam menyusun kalimat yang terdengar alami dan masuk akal. Namun, karena model ini tidak “memahami” arti sesungguhnya dari kata-kata tersebut, mereka bisa menyusun informasi yang salah namun terdengar meyakinkan.

“Large language models…tidak memiliki empati, tidak mengerti bahasa yang mereka hasilkan, tidak paham situasi yang sedang terjadi. Tapi teks yang mereka hasilkan terdengar masuk akal, sehingga orang cenderung menganggapnya bermakna.” Prof. Emily M. Bender, pakar linguistik dan AI

Pernyataan di atas menegaskan bahwa LLM hanya memanipulasi simbol (kata) berdasar pola statistik, bukan memahami isi atau konsekuensi ucapannya. Akibatnya, model bisa mengarang “fakta” dengan percaya diri sebuah fenomena yang dikenal sebagai hallucination dalam AI. ChatGPT, misalnya, dapat memberikan jawaban salah dengan detail meyakinkan (seperti nama kasus hukum fiktif, referensi ilmiah palsu, dsb.) karena ia menggabungkan potongan-potongan teks familiar dari data latihnya tanpa menyadari bahwa kombinasi tersebut keliru

Menariknya, para petinggi di bidang AI menyatakan bahwa kecenderungan LLM untuk berhalusinasi bukan cacat yang mudah diperbaiki, melainkan sifat alami dari cara kerjanya. CEO Google Sundar Pichai dalam sebuah wawancara menegaskan bahwa masalah hallucination pada AI “belum terpecahkan oleh siapapun di bidang ini” dan “dalam beberapa hal, halusinasi itu memang fitur inheren”. Ia menjelaskan bahwa justru karena model bahasa bisa “mengarang” maka ia mampu kreatif menghasilkan teks baru – misal langsung menulis puisi on-the-fly namun konsekuensinya, model yang sama tidak andal untuk memastikan fakta. “LLM bukan pendekatan terbaik jika selalu ingin fakta akurat,” kata Pichai.

Senada dengan itu, CEO OpenAI Sam Altman menyebut bahwa halusinasi AI “sama banyaknya fitur seperti halnya bug” dalam sistem generatif. Altman berargumen bahwa sejumlah besar kegunaan LLM justru muncul dari kemampuannya berimajinasi di luar data yang tentu berisiko salah, tetapi juga memungkinkan model memberikan jawaban yang out-of-the-box. “Kalau hanya mau cari info di database faktual, kan sudah ada mesin pencari,” ujarnya, sedangkan kelebihan LLM adalah bisa menjawab hal yang belum ada jawabannya secara kreatif. Pernyataan Pichai dan Altman mengindikasikan industri menerima bahwa halusinasi mustahil dihilangkan sepenuhnya tanpa mengorbankan kegunaan model, sehingga fokusnya bergeser ke mitigasi dan penanganan.

Dari sudut pandang ini, halusinasi dianggap “ciri alami” model generatif bukan berarti dibiarkan begitu saja, tetapi dipahami sebagai sesuatu yang perlu dikelola. Implikasinya, pengguna LLM harus menyadari kecenderungan tersebut sebagai keniscayaan teknis, bukan semata-mata kesalahan kode yang bisa ditambal. Hallucination adalah trade-off: ia muncul dari fleksibilitas model dalam mencipta (feature), namun menuntut kewaspadaan dalam penggunaan agar tidak disalahartikan sebagai kebenaran absolut (bug)

AI Belum Benar-Benar Cerdas: Perspektif Richard Sutton

Richard Sutton, salah satu pionir dalam bidang reinforcement learning dan peraih Turing Award, menegaskan bahwa AI saat ini belum bisa disebut benar-benar cerdas. LLM belajar dari data, bukan dari pengalaman. Sebaliknya, manusia belajar melalui interaksi nyata dengan dunia: mencoba, gagal, belajar, dan beradaptasi.

Untuk mendekatkan AI dengan kecerdasan manusia, pendekatan Reinforcement Learning (RL) diperlukan. Di sinilah model belajar melalui umpan balik, baik dari manusia maupun lingkungan, seperti cara anak kecil belajar. OpenAI, misalnya, menggunakan Reinforcement Learning from Human Feedback (RLHF) untuk melatih ChatGPT agar mampu memberikan respons yang lebih selaras dengan harapan pengguna.

Namun, pelatihan berbasis RL sangat mahal, memakan waktu, dan penuh risiko. Salah satu tantangan utama adalah catastrophic forgetting, yaitu ketika model melupakan pengetahuan sebelumnya setelah di-fine-tune. Ada juga risiko reward hacking, di mana model mencari cara “curang” untuk mencapai hasil terbaik menurut sistem reward-nya, meskipun sebenarnya tidak selaras dengan maksud pengguna.

Lima Prinsip Penggunaan AI yang Aman dan Efektif

Dengan semua risiko di atas, bagaimana cara menggunakan LLM secara bijak dan aman? Berikut lima prinsip utama yang dapat diikuti:

- Terima bahwa halusinasi adalah hal yang wajar. Kita tidak boleh menganggap semua keluaran AI sebagai kebenaran mutlak. Ketika sebuah jawaban terdengar masuk akal, bukan berarti itu benar.

- Gunakan prompt engineering secara tepat. Cara kita berinteraksi dengan AI sangat memengaruhi output-nya. Gunakan perintah yang jelas, spesifik, dan kontekstual agar hasilnya relevan dan tidak ambigu.

- Pastikan data bersih dan terpercaya. Data yang digunakan untuk melatih atau memberi konteks pada AI harus dikurasi dengan baik. Pepatah “garbage in, garbage out” sangat berlaku dalam dunia AI.

- Gabungkan NTP dengan RL untuk hasil yang lebih selaras dan logis. Meskipun menantang, menggabungkan pendekatan prediksi dengan pembelajaran dari pengalaman akan mendekatkan AI pada pemahaman yang lebih baik.

- Libatkan manusia dalam pengambilan keputusan. AI sebaik apapun tidak boleh menggantikan penilaian akhir manusia, terutama dalam konteks hukum, medis, dan kebijakan publik.

Menjaga AI Tetap Membumi

AI generatif seperti LLM memang menawarkan banyak manfaat: efisiensi, kreativitas, dan kecepatan. Namun, potensi bahayanya juga tidak boleh diabaikan. Justru karena kemampuannya semakin menyerupai manusia, kita harus semakin waspada agar tidak terkecoh oleh “kepintaran” palsunya.

AI adalah alat, bukan otoritas. Tugas kita adalah memahami cara kerjanya, mengenali batasannya, dan menggunakannya dengan penuh tanggung jawab. Dalam era kecerdasan buatan, kebijaksanaan manusialah yang menjadi kunci keselamatan.

Baca Juga :